性吧福利导航

微干事的架构体系中,不错毛糙的看作念是一个大行使拆分为多个小行使,小行使不错自成体系性吧福利导航,不错领有我方的数据库、框架以致于讲话等等,各个小行使一般通过Rest接口的神志被第三方、H5或者APP去调用。这个时候势必会存在一种情况,某些页面需要多个干事组合才智取得用户需要的信息。举个栗子:

[[417297]]

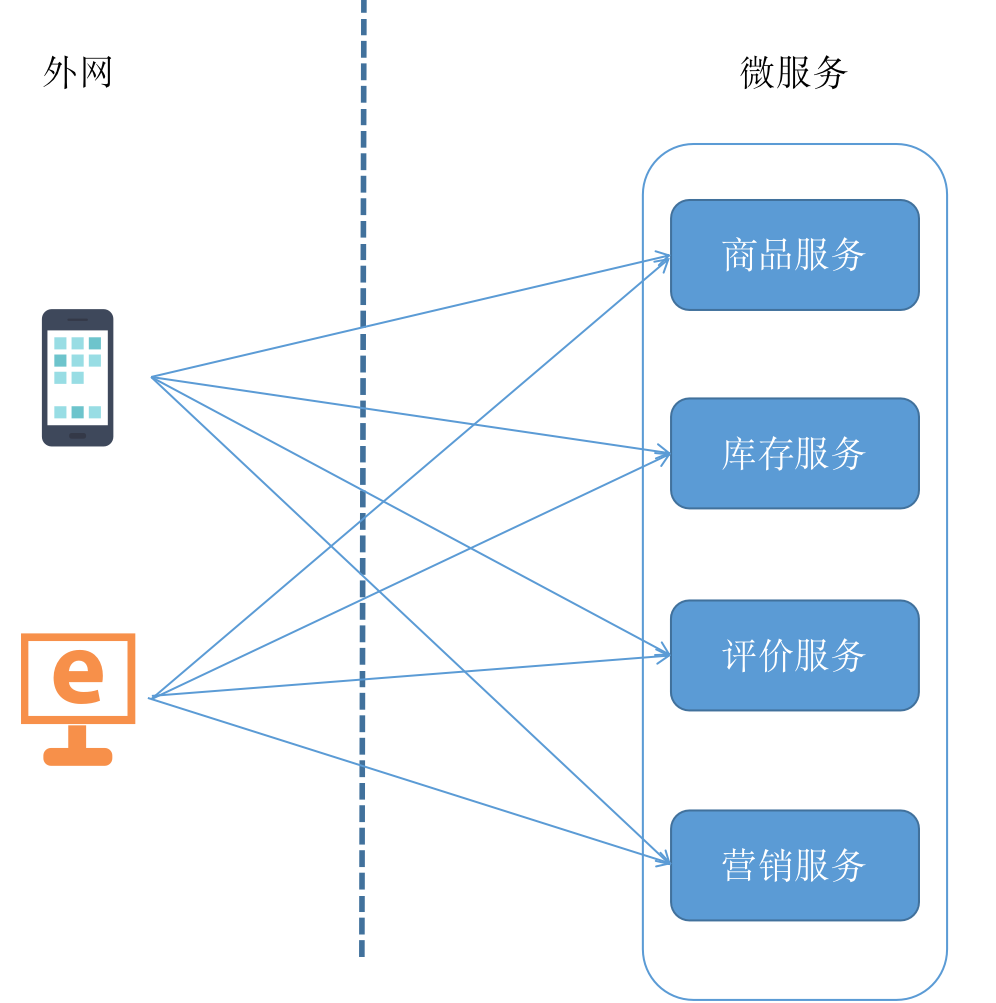

在电商系统中,查抄商品笃定页,这个商品笃定页包含商品的笃定,价钱,库存,辩论等,这些数据关于后端来说位于不同的微干事系统之中,后台的系统是这么来拆分干事的:

商品干事:矜重提供商品的标题,样子,规格等。 营销干事:矜重对居品进行订价,价钱政策计较,促销价等。 库存干事:矜重居品库存。 评价干事:矜重用户对商品的辩论,回话等。咱们不作念任那儿理的时候,调用的时候是这么:

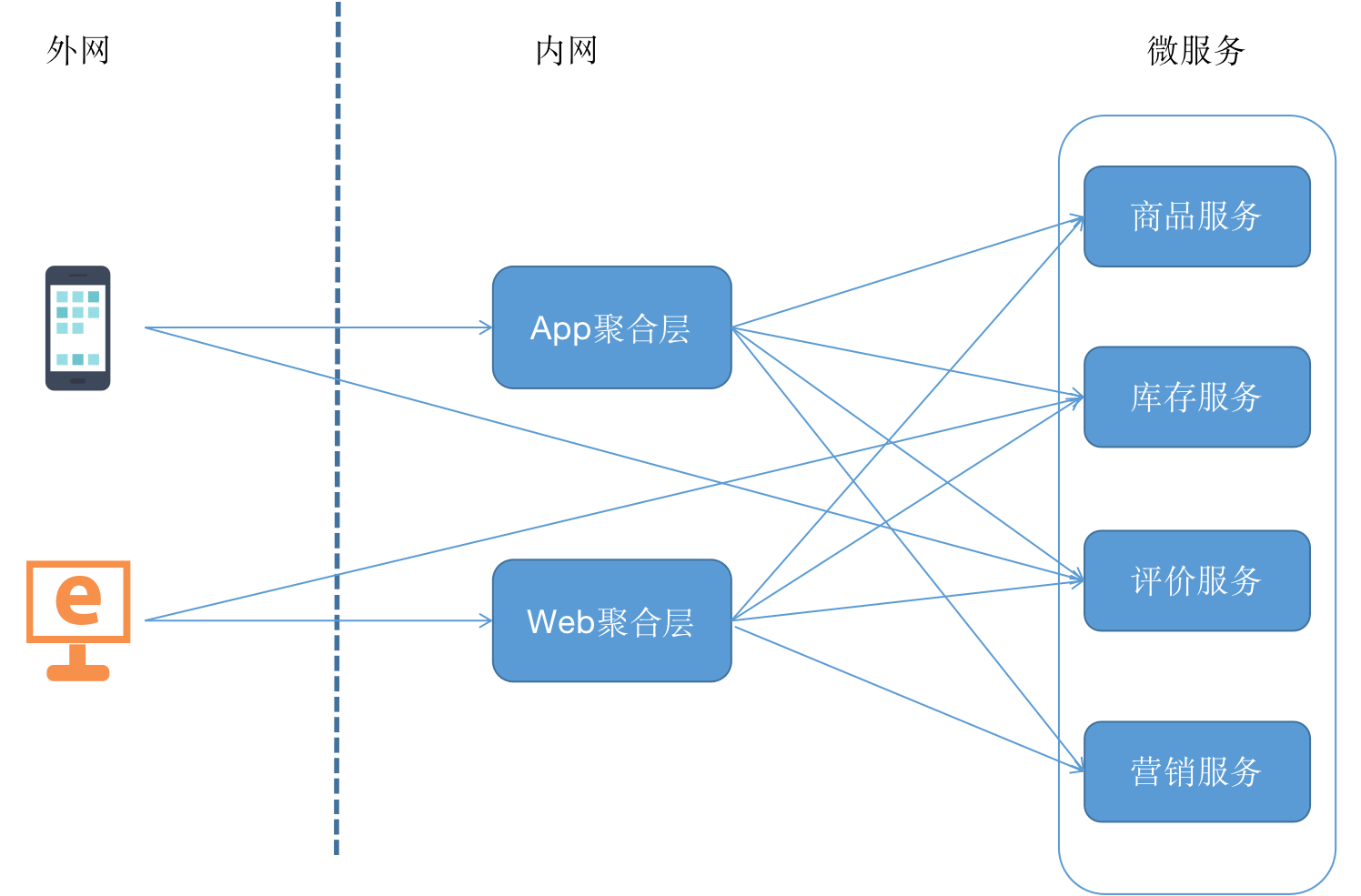

该处的症结即是前端需要调用屡次干事才智拿到咱们思要的数据,为了解决这个问题咱们不错作念一层中间的团员层,团员层也即是咱们频繁所说的BFF(Back-end for Front-end),BFF不错认为是一种适配干事,将后端的微干事进行适配(主要包括团员剪辑和设施适配等逻辑),收场上没太大适度,能作念苦求转发和数据转化即可,升级以后框架是这么的,之前咱们系统处于这个阶段:

多个团员层有许多跨横切面的代码是重迭的,比如安全认证,日记监控,限流熔断等,跟着时期的发展代码变得不行儿护;

跟着拜访量、业务的加多,两个BFF层也餍足不了咱们的业务,需要轮廓更多的BFF和摄取集群部署的风物。

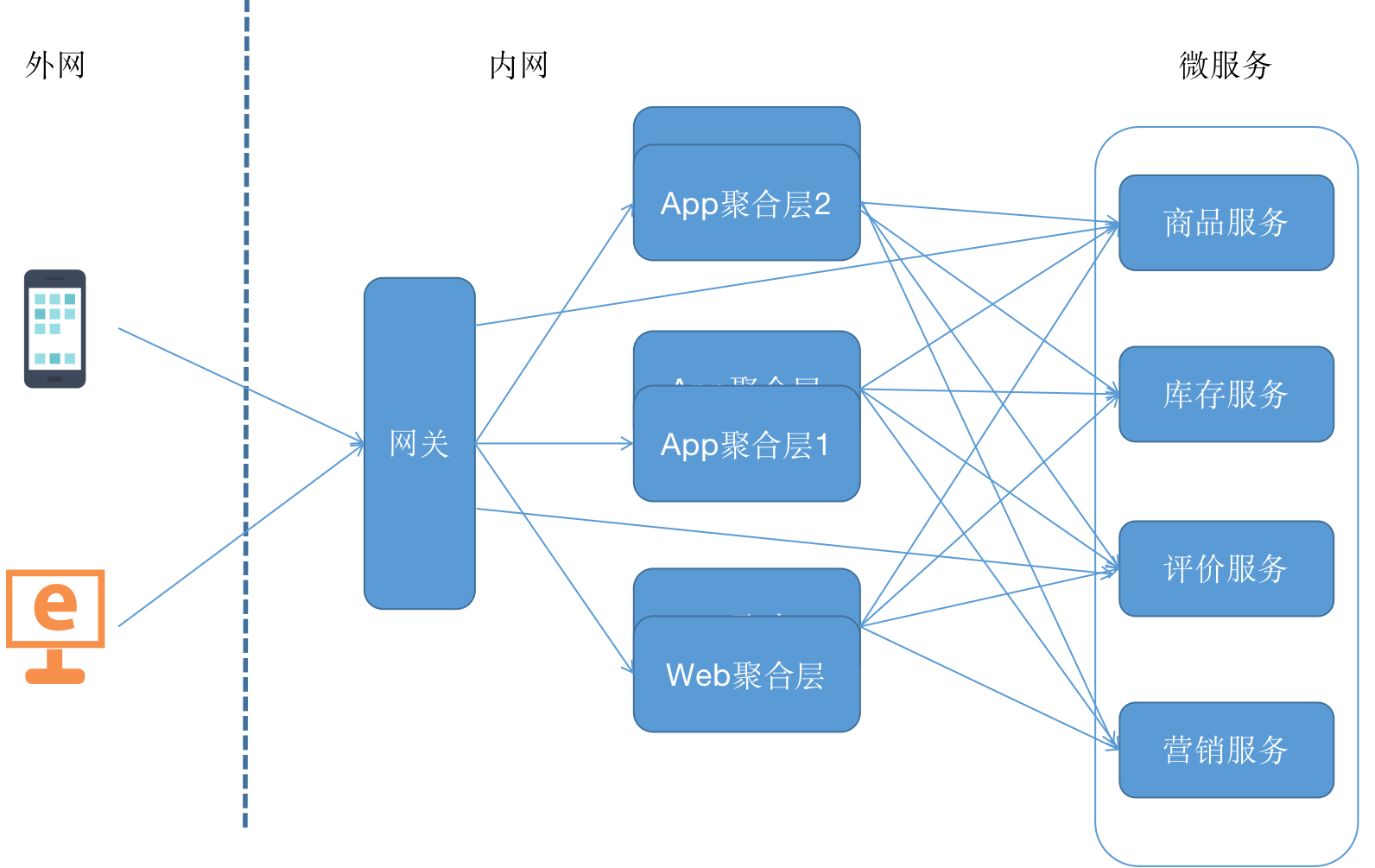

接下来咱们再次升级咱们架构,如下图:

这里咱们引入的咱们本章的主角网关,由于网关的加入咱们不错将扫数的跨横切面的代码通通轮廓到网关层,这么咱们BFF层只需要宽恕干事适配的逻辑,另外也解决掉了之前业务单点、多节点的等问题,这个时候你可能又思,网关的部署亦然单点了,这个时候你不错推敲在网关前挂一层NG或者F5,要是跟着业务发展网关管制的干事越来越多,也不错将网关按照业务域进行全体的拆分。

到这里你一定了解到了为什么需要网关,写到这里我倏得思到某个伟东说念主说的一句话,莫得什么是加一个中间层解决不了的,要是有,就加两个……,BFF也好、网关也好王人是咱们的中间层。

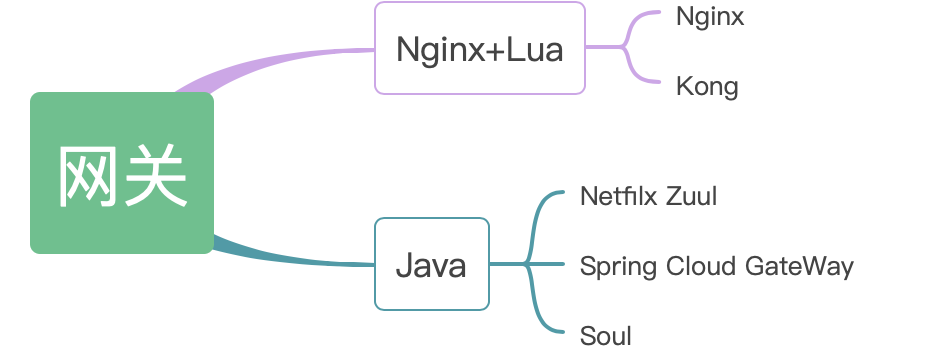

网关选型现在市面上凭证期间栈收场的不同大略有如下一些网关:

接下来咱们就毛糙了解下以上5个网关:

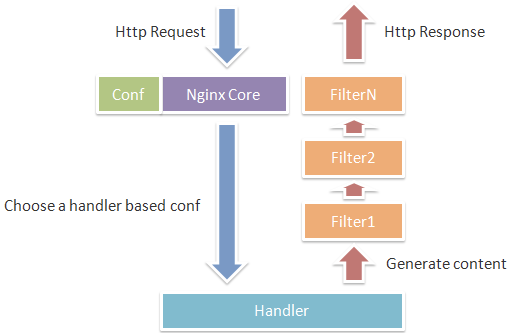

Nginx:Nginx由内核和模块构成,内核的谋划颠倒狭窄和蹂躏,完成的责任也颠倒毛糙,只是通过查找建立文献与客户端苦求进行URL匹配,用于启动不同的模块去完成相应的责任。

性吧福利导航

Nginx在启动后,会有一个Master进度和多个Worker进度,Master进度和Worker进度之间是通过进度间通讯进行交互的,如图所示。Worker责任进度的扯后腿点是在像select()、epoll_wait()等这么的I/O多路复用函数调用处,以恭候发生数据可读/写事件。Nginx摄取了异步非扯后腿的风物来处理苦求,也即是说,Nginx是不错同期处理多如牛毛个苦求的。

还不错将Lua镶嵌到Nginx中,从而不错使用Lua来编写剧本,这么就不错使用Lua编写行使剧本,部署到Nginx中启动,即Nginx酿成了一个Web容器;这么开发东说念主员就不错使用Lua讲话开发高性能Web行使了。在开发的时候使用OpenResty来搭建开发环境,OpenResty将Nginx中枢、LuaJIT、许多有效的Lua库和Nginx第三方模块打包在全部;这么只需要装置OpenResty,不需要了解Nginx中枢和写复杂的C/C++模块就不错,只需要使用Lua讲话进行Web行使开发了。

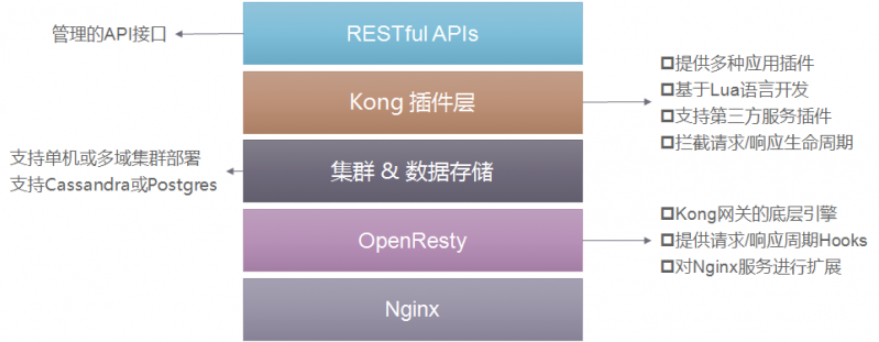

Kong:Kong是一款基于OpenResty(Nginx + Lua模块)编写的高可用、易扩张的,由Mashape公司开源的API Gateway式样。Kong是基于NGINX和Apache Cassandra或PostgreSQL构建的,能提供易于使用的RESTful API来操作和建立API管制系统,是以它不错水平扩张多个Kong干事器,通过前置的负载平衡建立把苦求均匀地分发到各个Server,来应付无数目的集聚苦求。

Kong主要有三个组件:

Kong Server:基于Nginx的干事器,用来接管API苦求。 Apache Cassandra/PostgreSQL:用来存储操作数据。 Kong dashboard:官方推选UI管制器具,虽然,也不错使用RESTful风物管制admin api。Kong摄取插件机制进行功能定制,插件集(不错是0或N个)在API苦求反馈轮回的人命周期中被实施。插件使用Lua编写,现在已有几个基础功能:HTTP基本认证、密钥认证、CORS(Cross-Origin Resource Sharing,跨域资源分享)、TCP、UDP、文献日记、API苦求限流、苦求转发以及Nginx监控。

Kong网关具有以下的特点:

可扩张性:通过毛糙地添加更多的干事器,柬埔寨修车群不错减轻地进行横向扩张,这意味着您的平台不错在一个较低负载的情况下处理任何苦求; 模块化:不错通过添加新的插件进行扩张,这些插件不错通过RESTful Admin API减轻建立; 在职何基础架构上启动:Kong网关不错在职何场所王人能启动。您不错在云或里面集聚环境中部署Kong,包括单个或多个数据中心树立,以及public,private 或invite-only APIs。 Netfilx Zuul:Zuul是Netflix开源的微干事网关组件,它不错和Eureka、Ribbon、Hystrix等组件合作使用。社区活跃,会通于Spring Cloud完整生态,是构建微干事体系前置网关干事的最好选型。

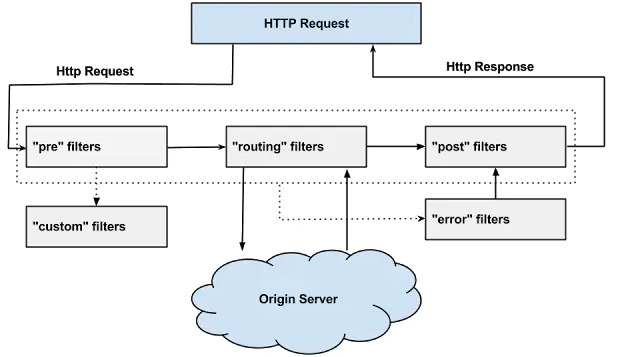

Zuul的中枢是一系列的filters,Zuul的中枢是一系列的过滤器,这些过滤器不错完成以下功能:

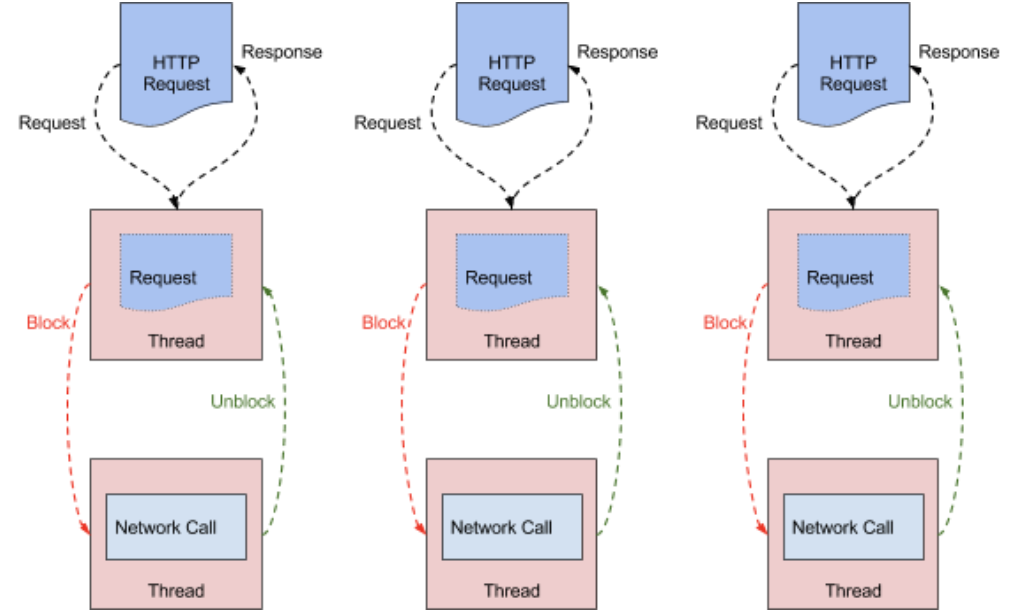

身份认证与安全:识别每个资源的考证条件,并拒却那些与条件不符的苦求。 审查与监控:与边际位置跟踪有有趣的数据和统计后果,从而带来精准的分娩视图。 动态路由:动态地将苦求路由到不同的后端集群。 压力测试:渐渐加多指向集群的流量,以了解性能。 负载分拨:为每一种负载类型分拨对应容量,并弃用超出落幕值的苦求。 静态反馈处理:在边际位置平直开发部分反馈,从而幸免其转发到里面集群。 多区域弹性:卓著AWS Region进行苦求路由,旨在收场ELB(Elastic Load Balancing,弹性负载平衡)使用的万般化,以及让系统的边际更逼近系统的使用者。 Zuul现在有两个大的版块:Zuul1和Zuul2。Zuul1是基于Servlet框架构建,如图所示,摄取的是扯后腿和多线程风物,即一个线程处理一次集会苦求,这种风物在里面延伸严重、开发故障较厚情况下会引起存活的集会增多和线程加多的情况发生。

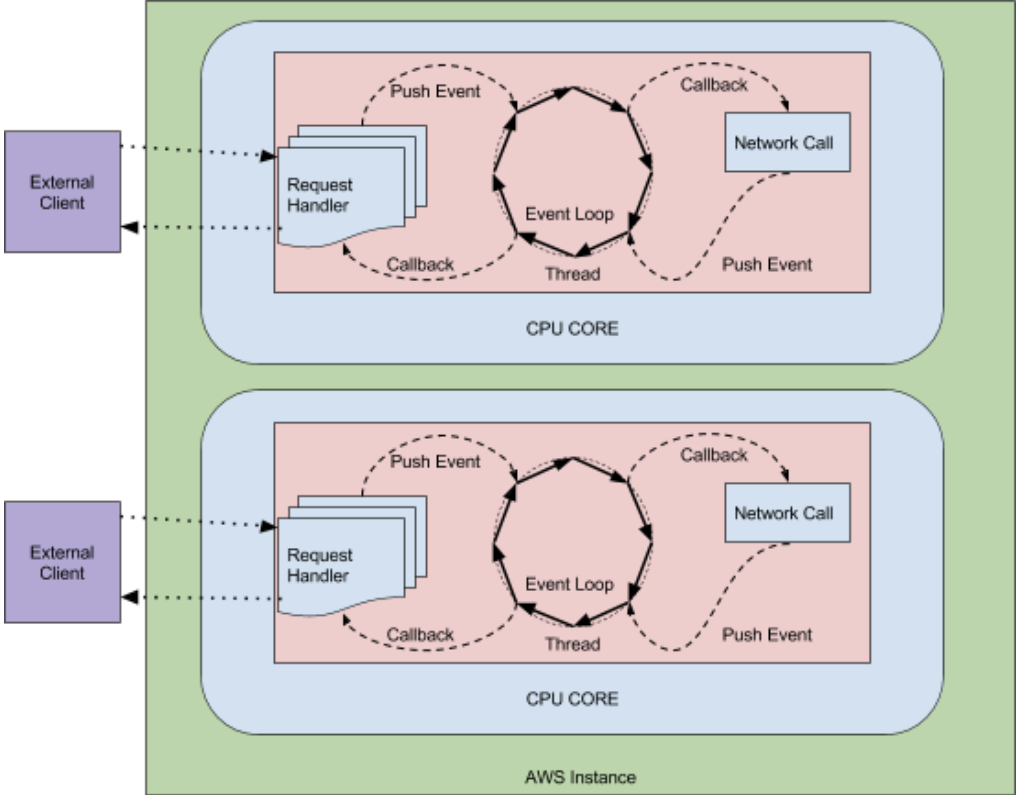

Netflix发布的Zuul2有要紧的更新,它启动在异步和无扯后腿框架上,每个CPU核一个线程,处理扫数的请乞降反馈,请乞降反馈的人命周期是通过事件和回调来处理的,这种风物减少了线程数目,因此支出较小。

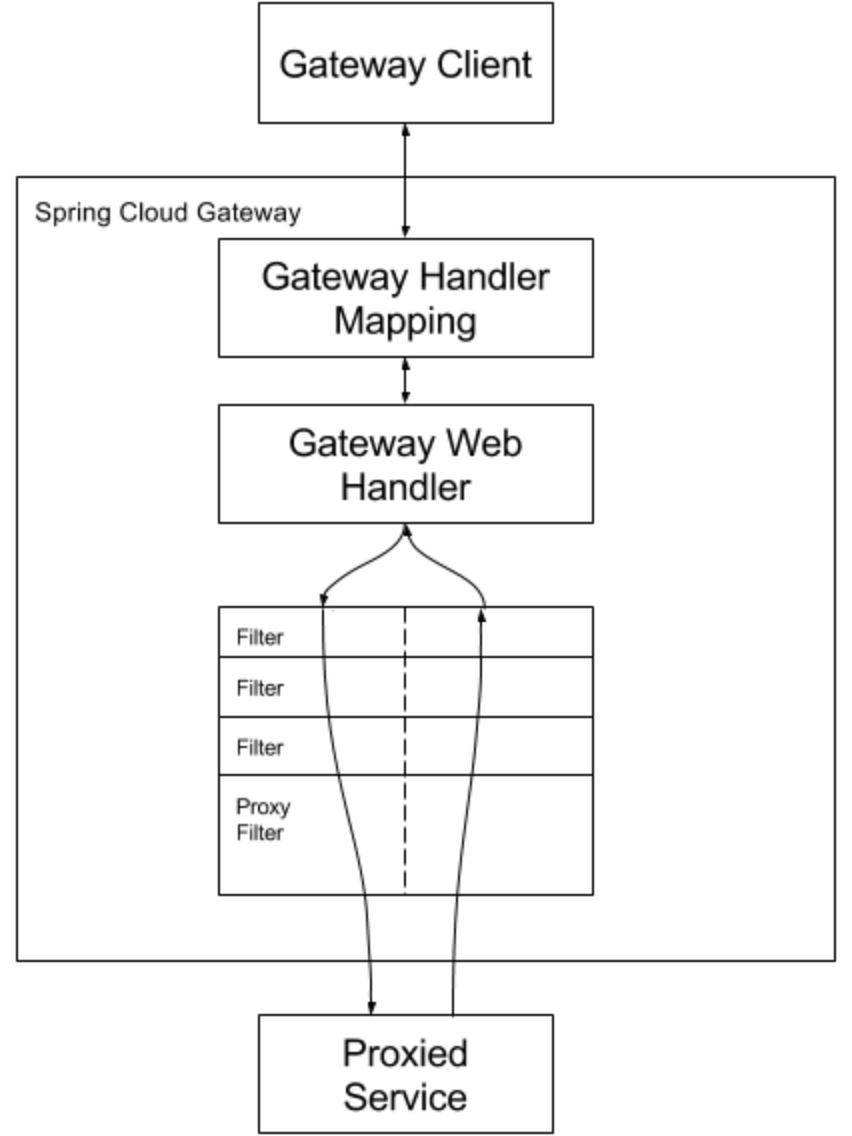

Spring Cloud GetWay:Spring Cloud Gateway是Spring Cloud的一个全新的API网关式样,方向是为了替换掉Zuul1。Gateway不错与Spring Cloud Discovery Client(如Eureka)、Ribbon、Hystrix等组件合作使用,收场路由转发、负载平衡、熔断等功能,何况Gateway还内置了限流过滤器,收场了限流的功能。

Gateway基于Spring 5、Spring Boot 2和Reactor构建,使用Netty行为启动时环境,比拟竣工的相沿异步非扯后腿编程。Netty使用非扯后腿的IO,线程处理模子开发在主从Reactors多线程模子上。其中Boss Group轮询到新集会后与Client开发集会,生成NioSocketChannel,将channel绑定到Worker;Worker Group轮询并处理Read、Write事件。

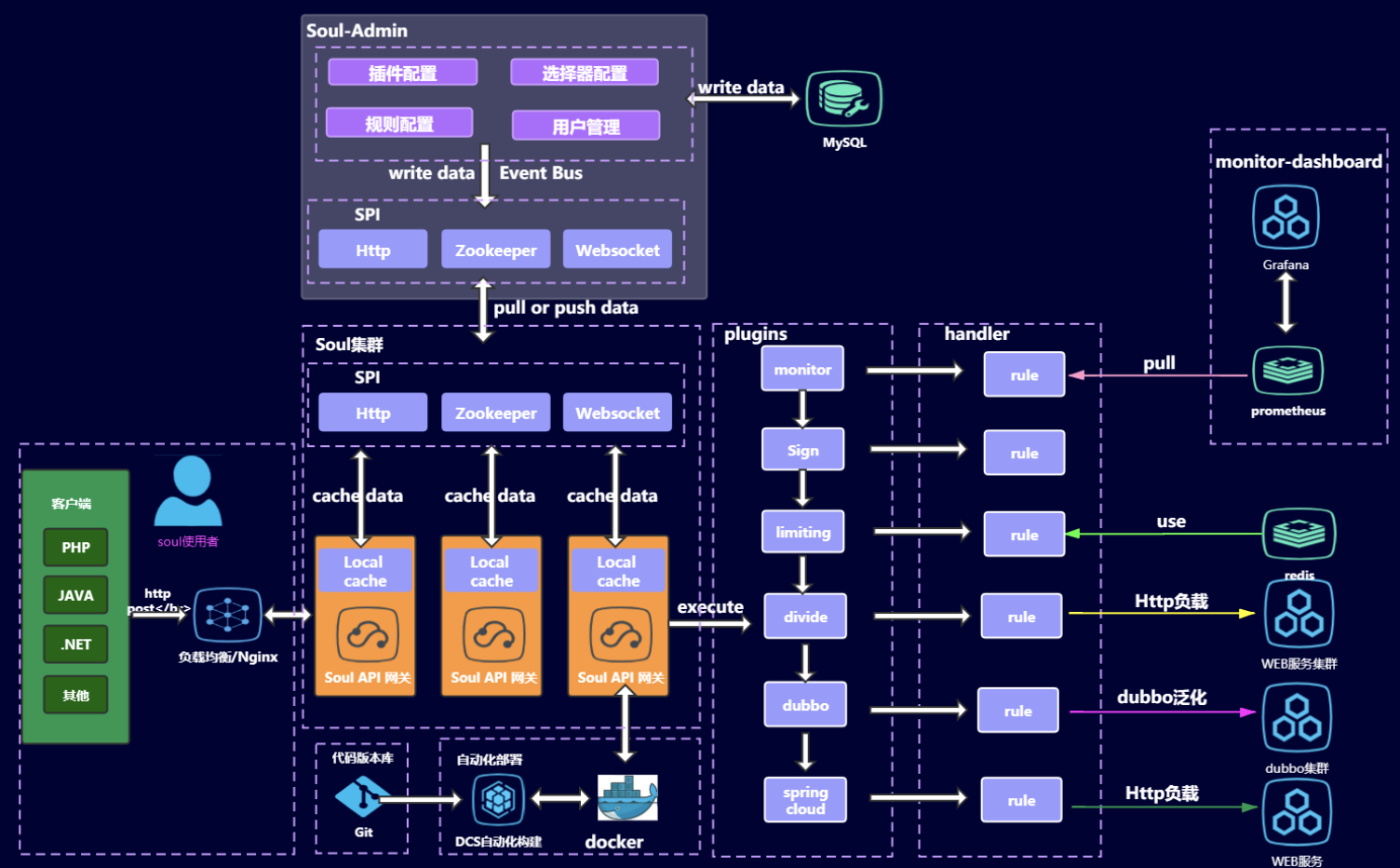

Soul:Soul是一个异步的,高性能的,跨讲话的,反馈式的API网关。参考了Kong,Spring-Cloud-Gateway等优秀的网关后,站在巨东说念主的肩膀上,Soul由此出生!

Soul特征:

相沿万般讲话,无缝集成Dubbo,Spring Cloud。 丰富的插件相沿,鉴权,限流,熔断,防火墙等等。 网关多种规定动态建立,相沿万般政策建立。 插件热插拔,易扩张 相沿集群部署,相沿A/B Test归来一下:

性能,Nginx+Lua神志势必是高于Java讲话收场的网关的,Java期间栈里面Zuul1.0是基于Servlet收场的,剩下王人是基于WebFlux收场,性能是高于基于Servlet收场的。在性能方面我合计聘任网关可能不算那么进犯,多加几台机器就不错惩处。 可儿护性和扩张性,Nginx+Lua这个组合掌抓的东说念主不算多,要是团队有大神,大佬们就任性了,当没看到这段话,关于一般团队来说的话,聘任我方团队擅长的讲话更进犯,是以我聘任了Java期间栈下的网关。Java期间栈下的3种网关,关于Zuul和Spring Cloud Getway需要或多或少要搞一些集成和建立页面来爱护,然而关于Soul我就无脑望望著作,需要哪个搬哪个好了,尤其是不错无脑对接Dubbo好意思滋滋,此外Soul2.0以后版块不错解脱ZK,在我心里再无诟病,我就心爱无脑操作。 高可用,关于网关高可用基本王人是息争的政策王人是摄取多机器部署的风物,前边挂一个负载,关于而外需要用的一些组件宇宙细心一下。